Talks

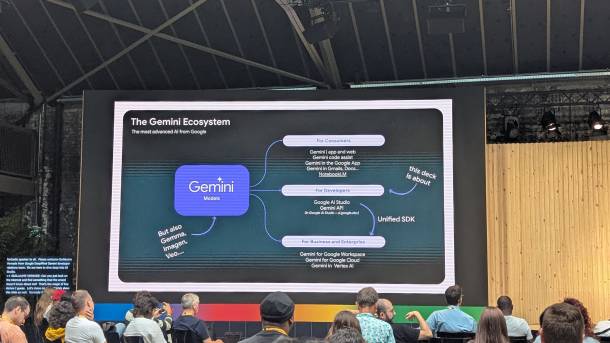

In sechs Zeitslots konnte man den eigenen Wissensdurst in den folgenden Kategorien stillen: AI, Cloud, Android und Web. Vieles, was gesagt wurde, war uns nicht komplett neu, da die meisten Neuerungen an oder direkt nach der Google I/O veröffentlicht worden waren und Google die Entwickler*innen-Community generell mit vielen informativen Videos versorgt. Daher haben wir verglichen mit der Droidcon im Herbst nicht unbedingt mehr Programmierwissen, sondern mehr Hands-on Erfahrung mit den neuesten Libraries und Tools, die Google veröffentlicht hat, erlangt.

Lieblingstalk von Dinah: Prototype with Google AI Studio

von: Guillaume Vernade, Gemini Developer Advocate, AI

Guillaume hatte einige coole Anwendungsfälle im Köcher, um die vielen Features in Google's AI Studio zu zeigen. AI Studio bringt einen enormen Mehrwert, weil Entwickler*innen mit den generativen KI-Modellen der Gemini-Familie experimentieren und Prototypen von Anwendungen erstellen und bereitstellen können.

Spracherkennung

Über den Menüpunkt "Generate Media" demonstrierte er, was die "Gemini speech recognition" so drauf hat. Dabei generierte er zuerst über den normalen Chat ein Drehbuch zu einem Podcast für ihn und eine zweite Person, indem er Gemini mehrere Links zu den neuesten AI-Features fütterte. Gemini gab ihm den Text aus, den er dann kopierte und unter "Gemini speech recognition" einfügte. Die Podcast-Hosts kann man benennen und ihnen eine Stimme zuteilen. Schon erhält man das Audio zu einem sehr authentisch klingenden Podcast zwischen zwei Personen.

Bildgenerierung & Videogenerierung

Diese Features sahen wir nur kurz, weil klar war, dass fast alle im Raum diese bereits einmal ausprobiert hatten. Die neuen Modelle Imagen 4 und Imagen 4 Ultra zeigen nun Texte im Bild nicht mehr in Hieroglyphen, sondern als wirklich lesbaren Text an. Veo 3, das Ende Sommer veröffentlicht wird, wird unter anderem automatisch passende Geräusche im Hintergrund einer Szene generieren.

Building apps

Schlussendlich demonstrierte Guillaume uns noch das Build-Feature. Damit kann man selbst Applikationen bauen, welche die verschiedenen Modelle nutzen. Sein Use-Case: ein Vocabulaire-Test-Generator für seine Tochter. Sie kann ein Foto der zu lernenden Wörtchen hochladen, Gemini erkennt die Wörter und erstellt einen Test mit passenden Sätzen. Zum Beispiel wird der Satz vorgelesen (Speech Generation) und die Tochter muss ihn korrekt eintippen. Im Optimalfall erkennt Gemini dann, ob die eingegebene Antwort korrekt ist oder nicht.

Abgesehen von all den verschiedenen Modellen, die man ausprobieren kann, ist für mich das tollste an AI Studio, dass man den Code einer Applikation, z. B. Lyria RealTime API, mittels "Show code editor" anzeigen und den Code Assistant einschalten kann. Der Lerneffekt ist so extrem hoch, weil man sieht, wie die Applikation programmiert ist und weil man sie direkt erweitern oder sie sich erklären lassen kann. Weiter kann man eine gebaute Applikation direkt mit anderen Benutzer*innen teilen oder sie auf Google Cloud deployen. Letzteres funktioniert, wenn man bereits eingerichtet ist, innert Sekunden!