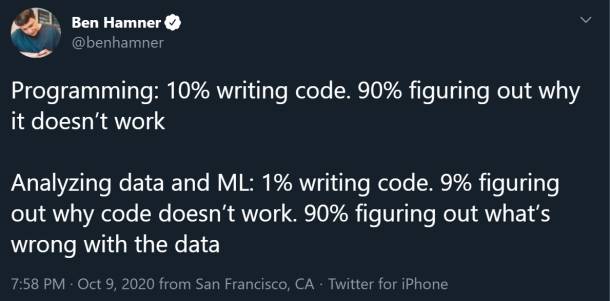

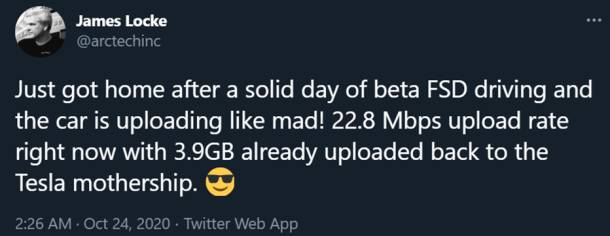

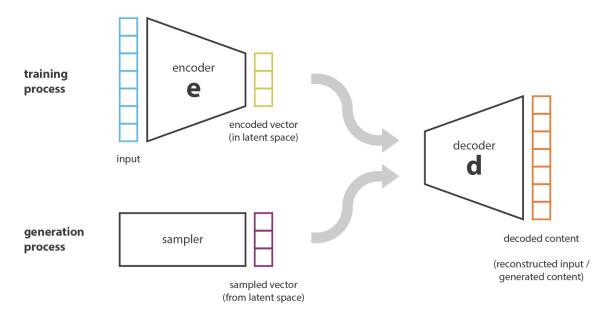

Maschinelles Lernen, Künstliche Intelligenz, Deep Learning, synthetische Daten - Begriffe die definitiv in die Sparte Trendwörter eingeordnet werden können. Während dem letzte Jahr haben wir das Startup Smartest Learning bei der Entwicklung ihrer App begleitet. Die Smartest App basiert auf der Idee, Lernmaterial schnell und einfach in interaktive Praxistests zu verwandeln. Dazu muss das Material lediglich via App gescannt werden, Smartest erstellt automatisch verschiedene Tests oder Lernkarten. Möglich macht dies die Kombination von Computer Vision und Natural Language Processing - beides Teilbereiche von Maschinellem Lernen. In diesem konkreten Fall werden erprobte Algorithmen und Datensätze verwendet. Aber was, wenn die grundlegenden Daten zuerst gesammelt und Datenmodelle zuerst erstellt werden müssen? Wie gelingt es, die Datenqualität sicher zu stellen?

Klingt nach komplexen Fragen - und die Materie ist auch alles andere als banal. Da wir aber finden, dass es sich um ein wichtiges Thema handelt, möchten wir unser Wissen möglichst einfach und verständlich weitergeben und so unsere Begeisterung dafür teilen.

Glücklicherweise haben wir einen Spezialisten in unseren eigenen Reihen, den wir dafür zu Wort kommen lassen. Pascal ist nämlich nicht "nur" unser Blockchain-Berater, sondern auch ein Experte wenn es ums Thema Maschinelles Lernen geht. Mit DAITA Technologies hat er eine Firma gegründet, die sich auf die Aufbereitung von Daten für künstliche Intelligenz spezialisiert.

Bühne frei für Pascals Ausführungen zum Thema Maschinelles Lernen und synthetische Daten!